本节需求

购买并初始化云服务器,完成端口放通与 Docker/Compose/Portainer 安装,使用 docker compose 部署 AI Agent 运行所需的组件(Ollama、Redis、向量库),配置 JDK 17 与 Maven,并拉取 DeepSeek R1 1.5B 模型完成联通验证。

云服务要求

AI Agent 至少需要 2C4G 的云服务器。阿里云学生优惠获取的2C2G服务器无法满足性能要求,因此建议购买新的实例以保证模型和服务的稳定运行。

腾讯云 4C4G 实例(79 元/年),性价比较高。参考:腾讯云服务器4C4G

选择Ubuntu 24.04-LTS即可,不需要额外的应用镜像

环境配置

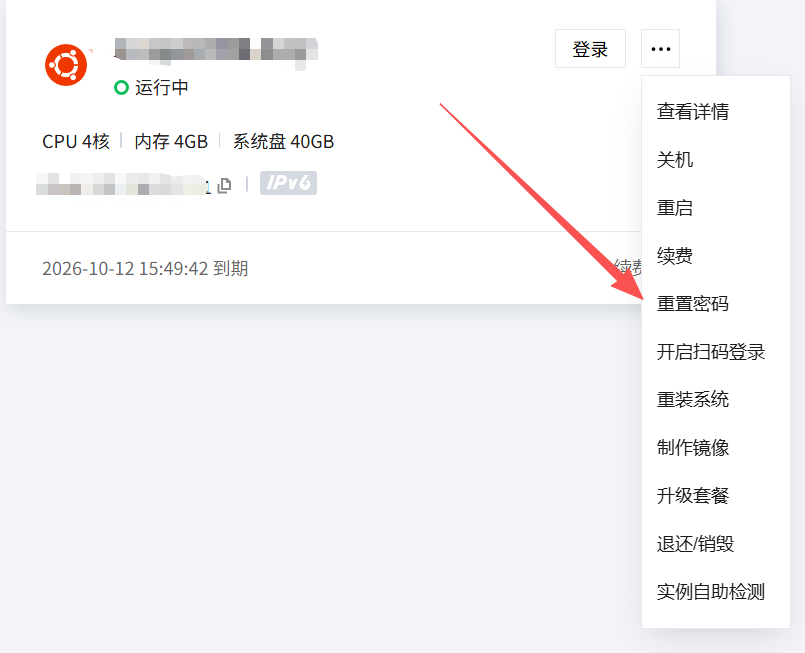

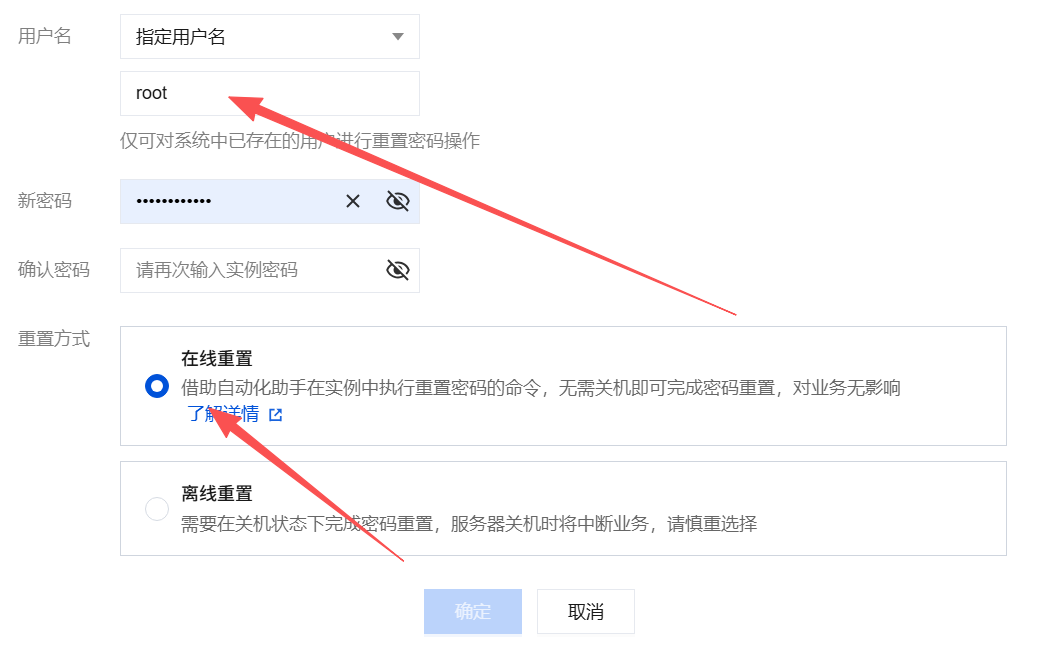

1. 重置密码

这里需要给 root 用户重置密码。

2. 防火墙开放

至少确保下列端口的开放:

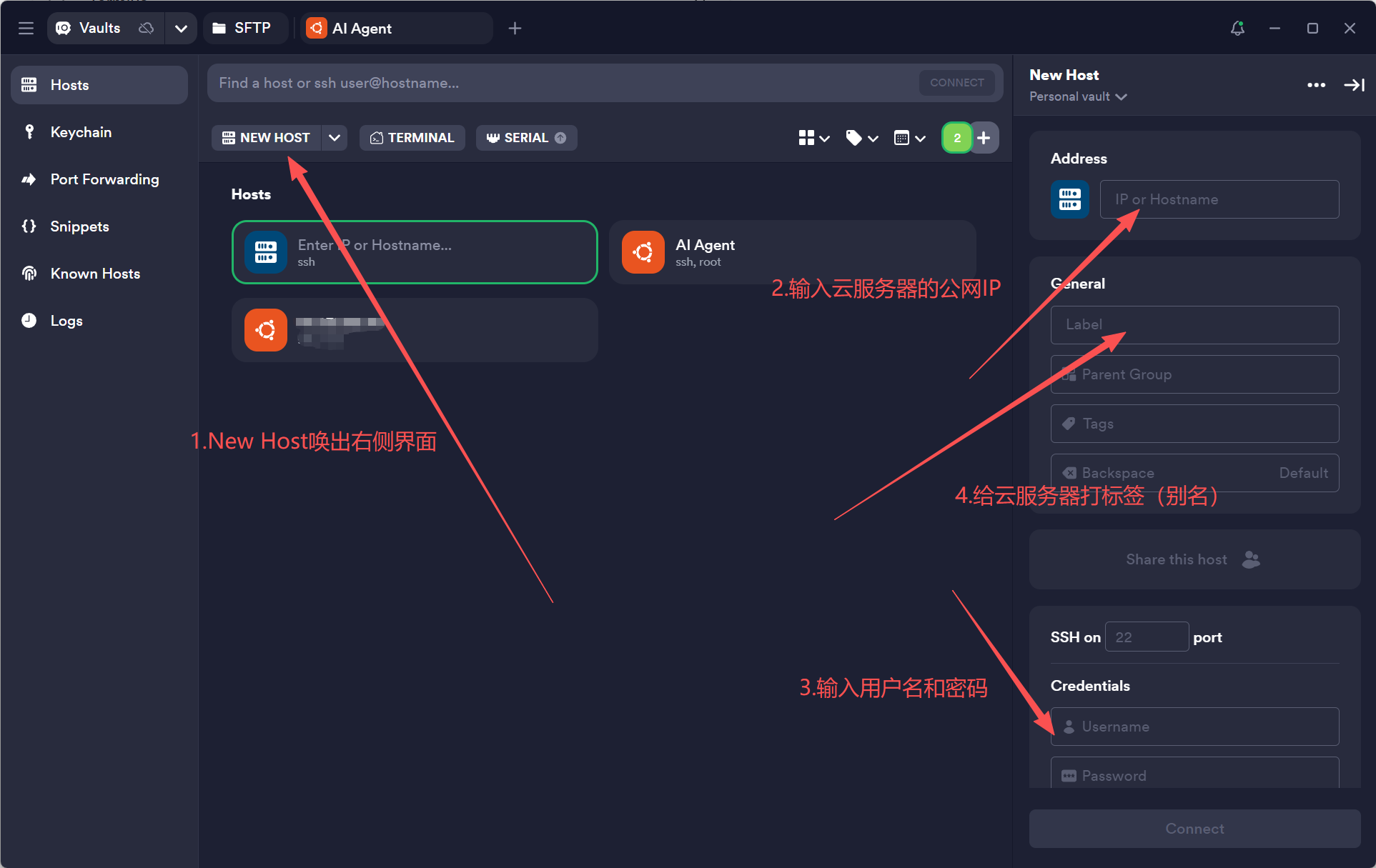

3. Termius 安装

4. Docker 安装

1 | # 下载并运行官方安装脚本 |

如果上述过程没有问题的话,则会显示:

5. AI-Agent 环境配置

创建并切换到 dev-ops 目录:

1 | cd / |

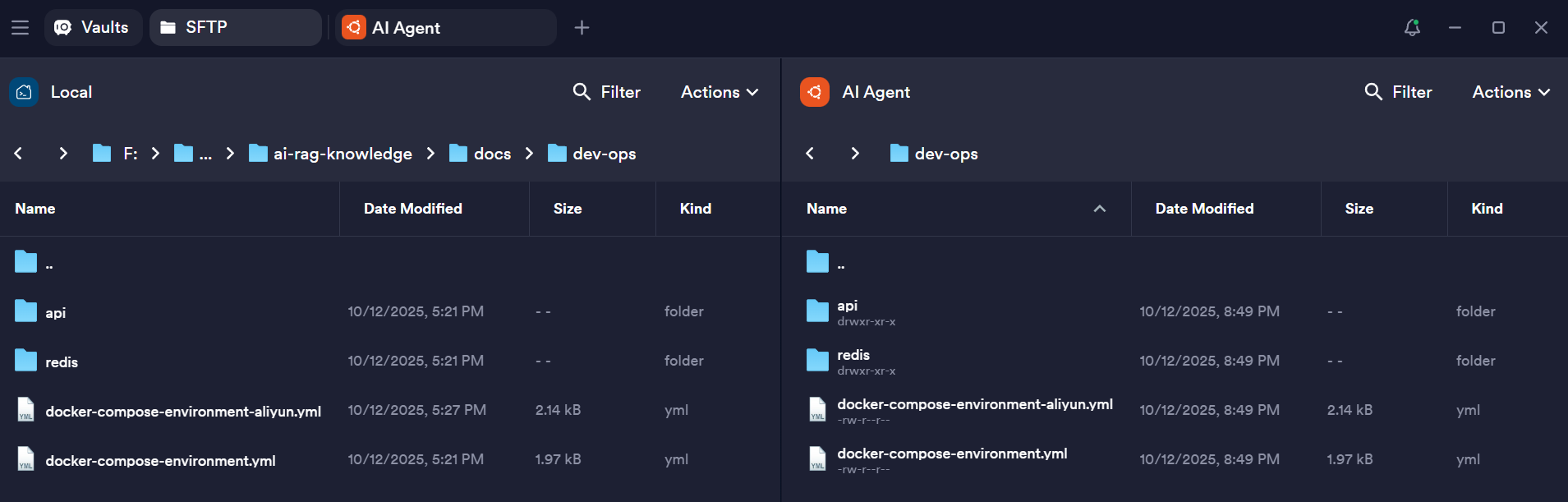

将项目中的 docs 目录下的内容移动至云服务器的 dev-ops 目录下(通过 Termius 的 SFTP):

然后执行如下命令:

1 | # 使用 docker compose(注意:部分老命令为 docker-compose) |

即可完成下列组件的安装和配置:

1. Ollama - 大语言模型服务

- 作用:运行本地化的大语言模型(如 deepseek-r1:1.5b)

- 用途:提供对话 AI、文本生成、代码解释等 AI 能力

- 端口:11434 - 可以通过 API 调用模型服务

2. Redis - 缓存和消息队列

- 作用:高速内存数据库,用作缓存和会话存储

- 用途:存储用户会话、缓存 AI 响应、临时数据

- 管理界面:通过 redis-admin 在 8081 端口可视化管理

- 账密:admin/admin

3. Vector DB - 向量数据库

- 作用:专门存储和检索向量数据的数据库

- 用途:存储文档嵌入向量,实现语义搜索、RAG(检索增强生成)

- 数据库:ai-rag-knowledge

接下来需要完成 Maven,JDK 17 的配置:

1 | # 1. 安装 JDK 17 和 Maven |

6. DeepSeek R1 1.5B 模型安装

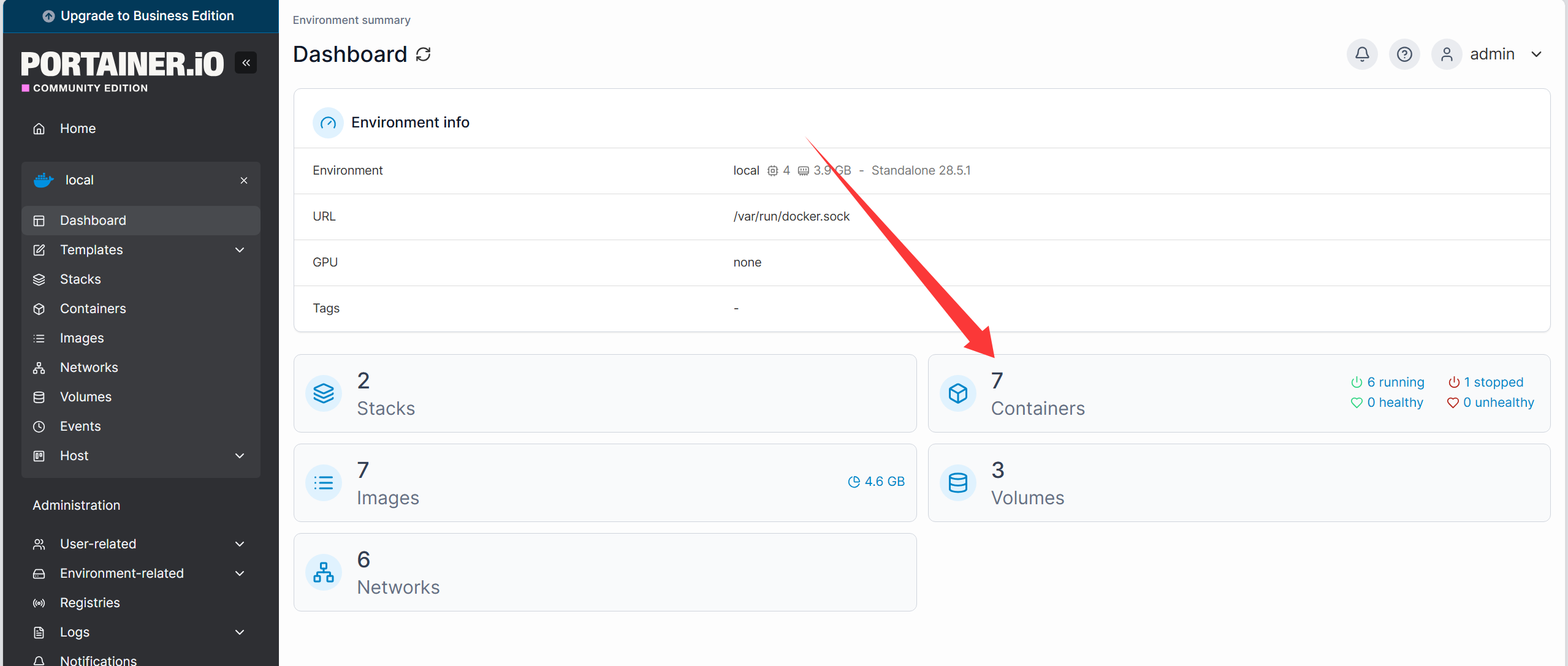

1. 安装 portainer

1 | docker volume create portainer_data |

- 防火墙开启 9000 端口

- 立即访问:

<公网IP:9000>进入portainer界面 - 首次登录需要设置管理员账号的用户名和密码

2. 安装 Deepseek R1

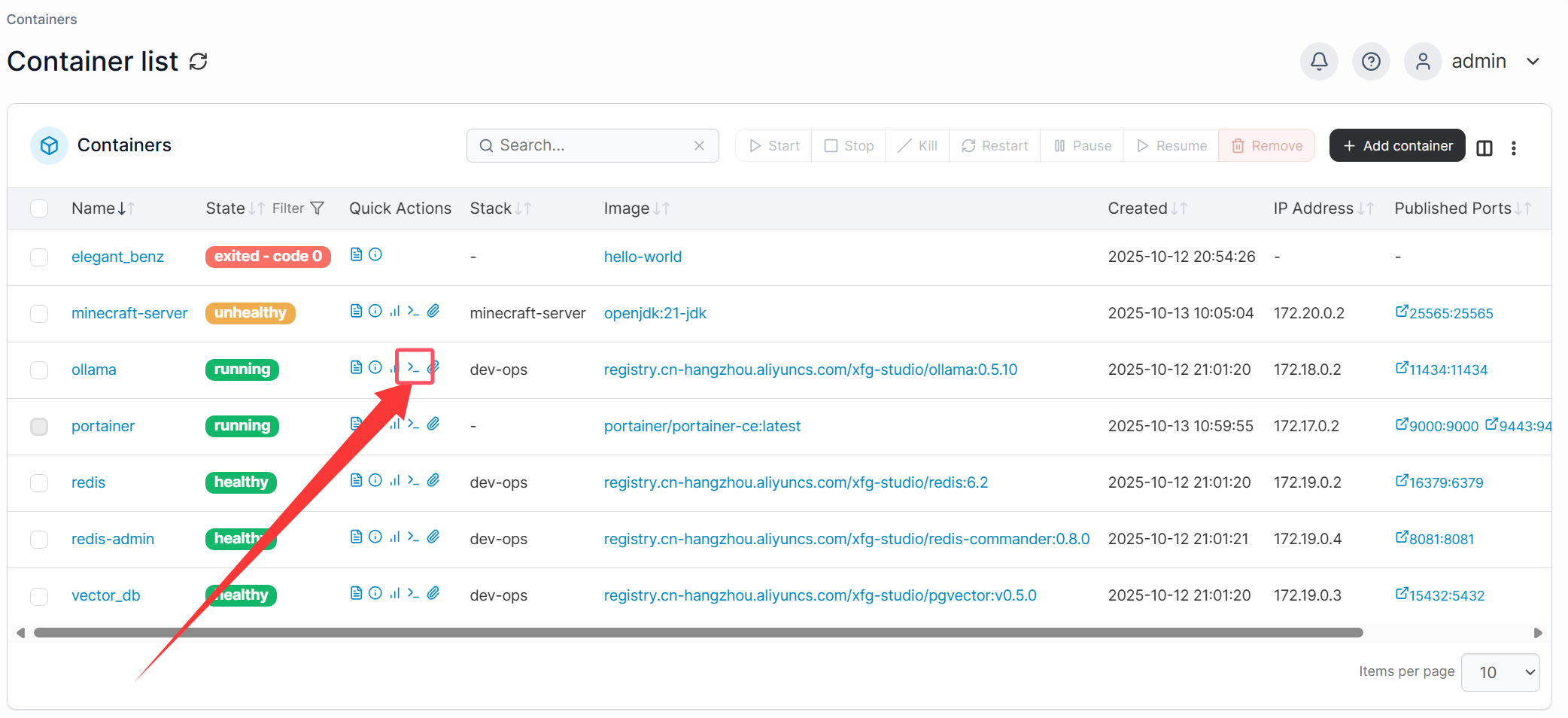

在 portainer 中完成如下操作:

然后 Connect,依次输入如下命令:

1 | # 拉取模型,推荐小一点,够做开发就可以 |

命令执行完毕后,即可与 AI 对话:

- 输入

/exit退出对话

3. 通过其他途径访问

1. 可以像小傅哥项目中提到的用 sh 脚本:

1 | curl http://<ipv4地址>:11434/api/generate \ |

5. 也可以用 apifox 发起请求

Body:

1 | { |

Headers:

成功响应!